微軟正式發佈Maia 200 AI晶片 挑戰Nvidia和Google的推論霸權

微軟在2026年1月26日正式揭幕第二代自研AI晶片 Maia 200,這款推論加速器標誌著科技巨頭在打破Nvidia軟體生態壟斷方面的重大進展。Maia 200已於本週在愛荷華州資料中心上線,後續將部署至亞利桑那州鳳凰城,預計成為微軟Azure雲端基礎設施的關鍵動力[1]。

Maia 200:終結Nvidia推論壟斷的重型火力

超越Amazon和Google的性能指標

微軟執行副總裁Scott Guthrie宣布,Maia 200提供「30%更優秀的每美元性能」,相較於微軟目前最新一代硬體設施,是微軟部署過效能最高的推論系統[1]。根據官方規格,這款晶片在關鍵效能指標上全面領先競爭對手:

- FP4精度下超過10 PetaFLOPS(Amazon第三代Trainium的3倍)

- FP8精度下超過5 PetaFLOPS(超越Google第七代TPU)

- 記憶體配置:216GB HBM3e(高頻寬記憶體),頻寬達7 TB/s

- 晶片內SRAM:272MB,用於低精度推論優化

相比之下,Amazon Trainium3僅配備144GB HBM,Google TPU v7 Ironwood為192GB HBM3e。

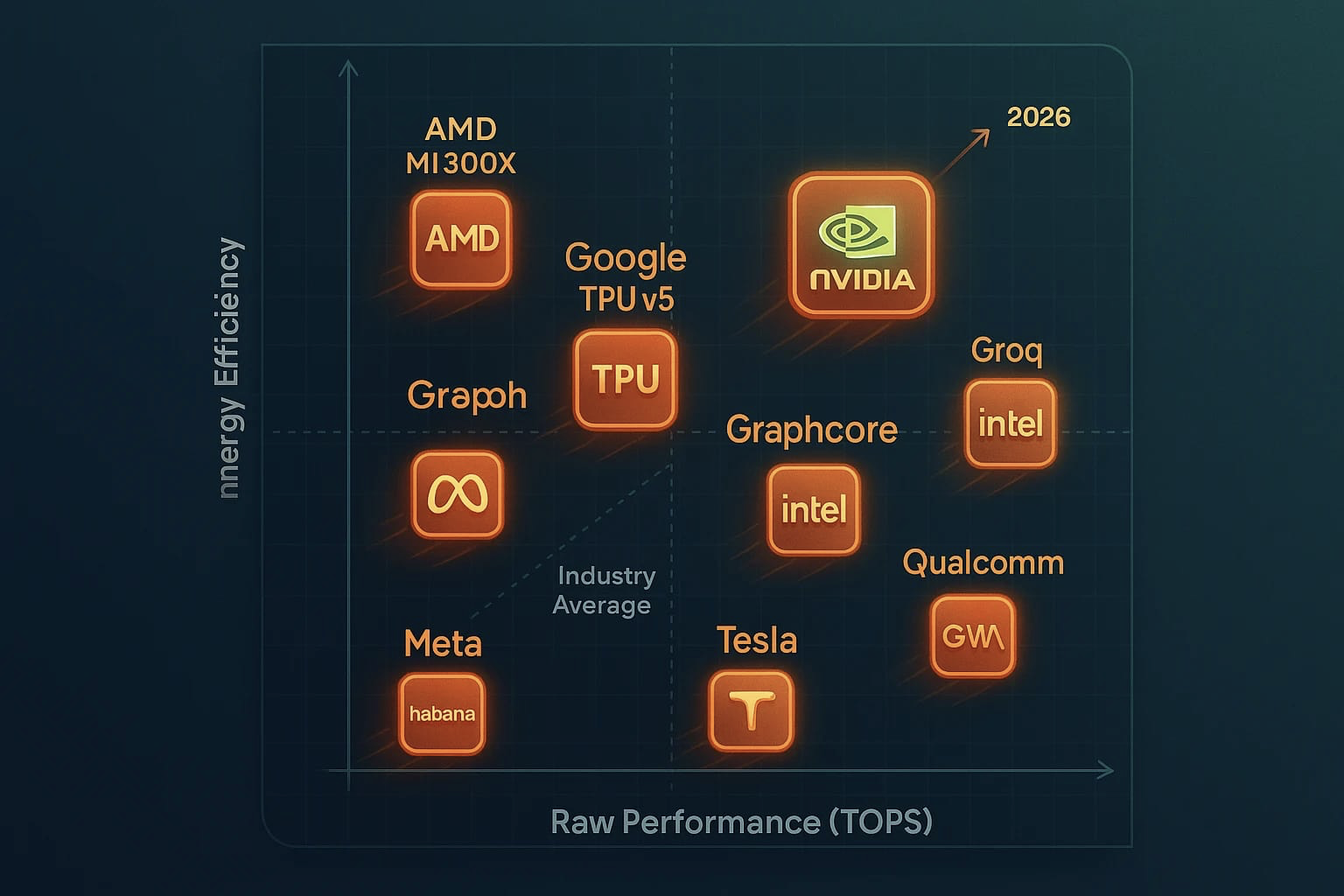

Figure 2: 圖2:AI推論晶片性能排名對比——Maia 200領先Nvidia、Amazon、Google競品

3奈米製程+低精度計算的完美組合

Maia 200採用台積電(TSMC)3奈米製程製造,內建140億個電晶體[3]。晶片在750W功耗包絡內運作,相較Nvidia最新Blackwell B300 Ultra的1400W功耗,效率提升超過一倍。這種功耗優勢對於面臨電力成本壓力的大型資料中心至關重要[2]。

微軟將設計重心放在低精度計算,特別是FP4(4位元精度)和FP8(8位元精度)。相較於傳統的BF16或FP32,FP4能在保持推論準確度的前提下,大幅降低運算和記憶體成本,實現「每美元更多Token生成」的經濟效應。

「實際上,單一Maia 200節點能輕鬆運行當今最大的AI模型,且還有充足的空間應對未來更龐大的模型」,Scott Guthrie在部落格中指出。

軟體堆棧突破:Triton編譯器降低遷移門檻

除了硬體優勢,微軟同步推出 Maia軟體開發工具包(SDK),整合業界主流框架[1]:

|

軟體元件 |

功能說明 |

|

Triton編譯器 |

開源程式設計工具,使無GPU經驗開發者能撰寫與專家程度相當的程式碼 |

|

PyTorch支援 |

相容主流機器學習框架 |

|

NPL編程 |

專有程式語言支援 |

|

模擬器與成本計算機 |

幫助開發者預估效能與成本 |

Triton編譯器由OpenAI主導開發,2021年首次發佈,標誌著微軟向Nvidia CUDA生態的有力挑戰。這套工具大幅降低從Nvidia轉向Maia平台的遷移成本,反制了長期以來Nvidia透過軟體鎖定客戶的策略[4]。

Figure 3: 圖3:Nvidia競爭者生態——微軟Maia、Amazon Trainium、Google TPU並行開發

記憶體架構創新:解決AI推論的資料流瓶頸

與傳統著重計算峰值不同,Maia 200的創新核心在於記憶體子系統設計。微軟工程團隊導入:

- 多層級DMA(直接記憶體存取)引擎,減少資料移動延遲

- 階層式片上網路(NoC),分離張量流量與控制流量通道

- 軟體可管理的SRAM池,開發者能精確控制資料局部性

- 7TB/s的HBM頻寬,確保持續供應模型權重

這套架構反映了一個關鍵洞察:AI推論的效能瓶頸不在計算,而在資料供應。透過優化記憶體層級結構,Maia 200能以較少的晶片級聯實現大規模推論,進而降低總擁有成本(TCO)[2][5]。

Figure 4: 圖4:Azure AI架構技術細節——記憶體層級與資料流優化設計

部署現況與應用場景

Maia 200目前已納入微軟三大應用場景[1]:

- 微軟Superintelligence團隊:用於強化學習與合成資料生成,加速下一代大語言模型開發

- Azure AI Foundry與Microsoft 365 Copilot:為企業AI應用與生產力工具提供推論引擎

- 異構加速器佈局:與CPU、GPU及其他加速器並行運作,供客戶靈活選擇最適工作負載的硬體配置

微軟表示可規模化至多達6,144個Maia 200晶片連結,透過標準Ethernet(而非Nvidia的InfiniBand標準)實現高效率的跨多加速器協調[3]。

Figure 5: 圖5:Microsoft Azure基礎設施——支援高效能AI晶片規模化部署

雲端巨頭的晶片自主之戰

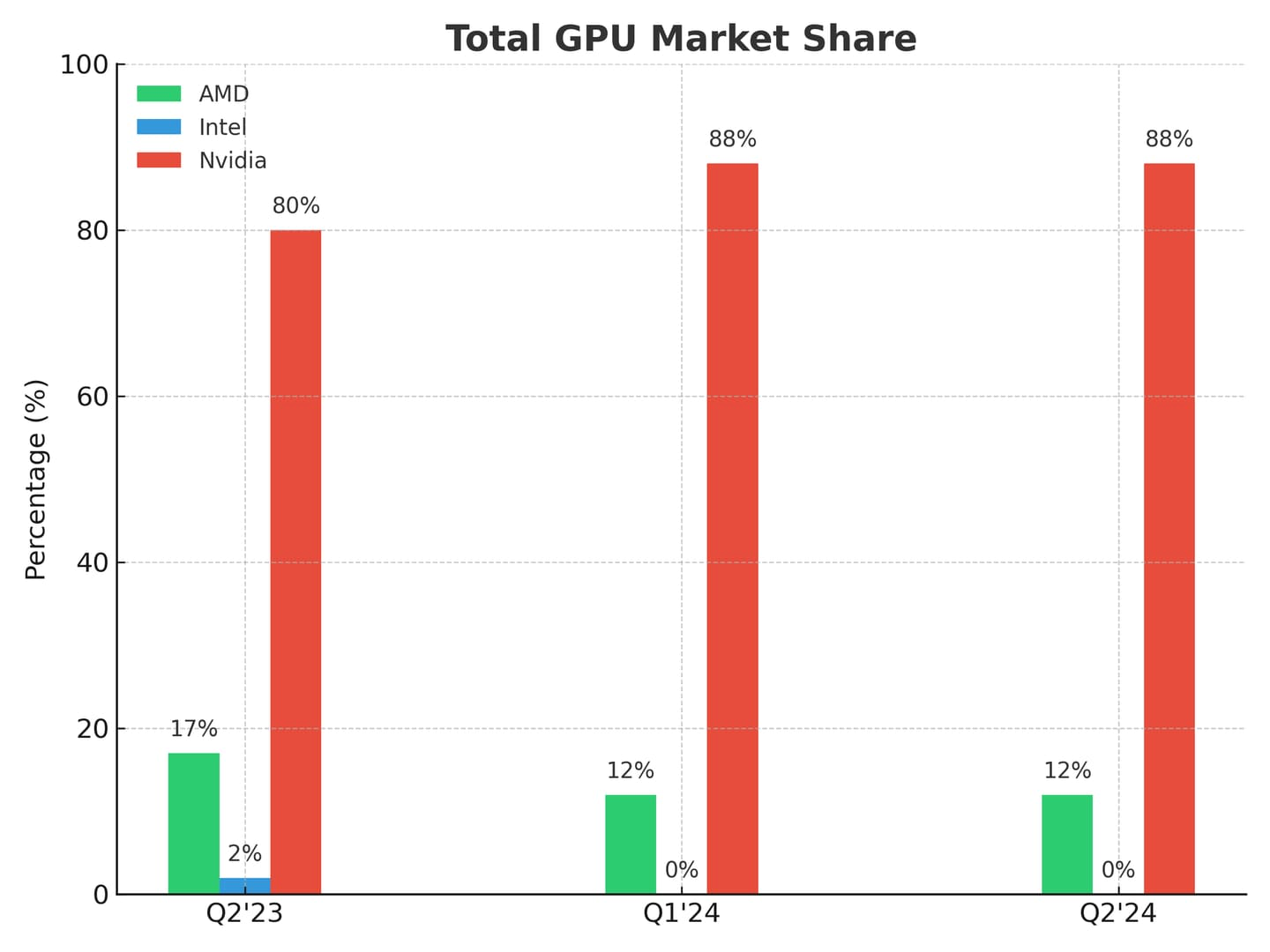

Maia 200的發佈象徵著雲端產業的結構性轉變。目前Nvidia掌握約85%的AI加速器市場份額,但Amazon、Google與微軟正透過自研晶片打破這一壟斷格局[4]。

微軟的策略特色在於:

- 軟體與硬體整合:Maia不只是晶片,更是完整的推論平台

- 開源友善:Triton編譯器相容PyTorch等開源框架,降低開發者進入門檻

- 成本導向:著重每美元效能與每瓦效率,直指超大規模資料中心的關鍵痛點

- 異構相容:設計與Azure現有CPU/GPU生態無縫整合,無需全面替換基礎設施

相比之下,Amazon的Trainium3與Inferentia、Google的TPU v7等友敵晶片雖具特色,但在通用推論領域的綜合競爭力與軟體生態仍有差距[2]。

Figure 6: 圖6:Microsoft超越Nvidia戰略——從AI晶片到完整推論生態

展望:Maia生態的未來

微軟已開放Maia 200 SDK預覽版予開發者、學術機構、前沿AI實驗室及開源貢獻者申請[1]。這意味著Maia不再侷限於微軟內部使用,而是邁向廣泛客戶可及性的重要一步。

考慮到Maia 200的開發歷程(原定2025年發佈,因OpenAI需求變更與團隊更替而延期至2026年),微軟下一代晶片據報將採用Intel Foundry的18A製程,進一步拉大與競爭對手的技術領先距離[3]。

Figure 7: 圖7:Microsoft AI基礎設施投資規劃——超大規模資料中心擴張藍圖

結論:AI晶片戰爭的新階段

Maia 200的推出,不僅是微軟的技術勝利,更標誌著AI推論基礎設施的民主化時代開始。從Nvidia掌握軟硬體全套生態,到如今多家超大規模雲端服務商(Amazon、Google、微軟)各展所長,AI晶片市場正進入百花齊放的競爭格局。

對於仰賴雲端推論服務的開發者而言,選擇更加多元;對於致力降低營運成本的企業而言,這是出現成本優化的良機。微軟透過Maia 200與完整的軟體堆棧,正式向Nvidia的推論霸權發起有力挑戰。

References

[1] Microsoft. (2026, January 26). Maia 200: The AI accelerator built for inference. Microsoft Blog. https://blogs.microsoft.com/blog/2026/01/26/maia-200-the-ai-accelerator-built-for-inference/

[2] Tom's Hardware. (2026, January 25). Microsoft introduces newest in-house AI chip — Maia 200 is faster than other bespoke Nvidia competitors. https://www.tomshardware.com/pc-components/cpus/microsoft-introduces-newest-in-house-ai-chip-maia-200

[3] Storage Review. (2026, January 25). Maia 200 signals Microsoft's push toward custom silicon for AI inference. https://www.storagereview.com/news/maia-200-signals-microsofts-push-toward-custom-silicon-for-ai-inference

[4] TechCrunch. (2026, January 26). Microsoft announces powerful new chip for AI inference. https://techcrunch.com/2026/01/26/microsoft-announces-powerful-new-chip-for-ai-inference/

[5] Network World. (2026, January 25). Microsoft launches its second generation AI inference chip Maia 200. https://www.networkworld.com/article/4122439/microsoft-launches-its-second-generation-ai-inference-chip-maia-200.html