Nvidia計劃明年推出更強大的AI超級晶片,以滿足大型AI模型需求

隨著對運行大型AI模型的需求持續增加,目前已經是高端AI處理器市場領導者的Nvidia,宣布了其GH200 Grace Hopper 超級晶片將計畫在明年推出,該晶片旨在滿足運行大型AI模型所需的龐大計算需求,他們計劃透過GH200超級晶片在AI領域有更進一步的影響力。

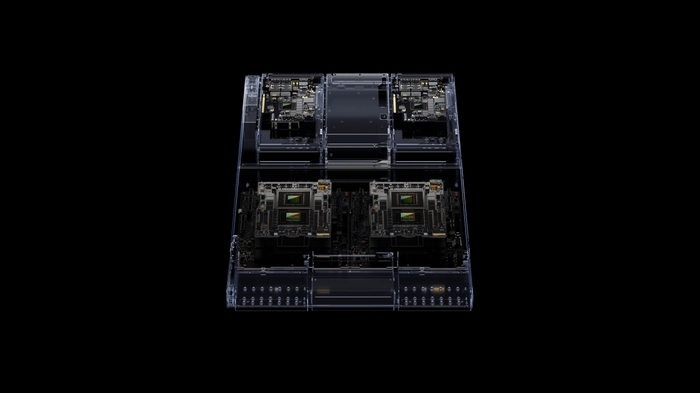

GH200 Grace Hopper超級晶片

隨著對運行大型AI模型的需求持續增加,目前已經是高端AI處理器市場領導者的Nvidia,宣布其GH200 Grace Hopper 超級晶片將計畫在明年推出,該晶片旨在滿足運行大型AI模型所需的龐大計算需求,他們計劃透過GH200超級晶片在AI領域有更進一步的影響力,Nvidia宣稱該晶片能夠處理最複雜的生成式AI工作負載,包括大型語言模型、推薦系統和向量數據庫。

該晶片提供多種不同的配置,其中包括雙配置,其內存容量較前一代產品提高3.5倍,帶寬也增加了3倍。其中一個單一服務器搭載了144個Arm Neoverse核心,提供了高達8千億次的AI性能,同時搭載最新的282GB HBM3e內存技術。

NVIDIA創始人兼首席執行官黃仁勳表示:“為了滿足生成式AI的不斷增長需求,數據中心需要專為此需求設計。”他指出:“全新的GH200 Grace Hopper Superchip通過卓越的內存技術和帶寬提升,提高了吞吐量,實現了將GPU聯接在一起以合併性能,並且採用了易於在整個數據中心部署的服務器設計。”

Grace Hopper Superchip可以通過NVIDIA NVLink™技術與其他Superchip連接,使它們能夠共同運行,以支持部署生成式AI所需的大型模型。這種高速和協同作業的技術使GPU能夠完全訪問CPU內存。在雙配置模式下,這一技術能夠提供總計1.2TB的快速內存。

而HBM3e內存速度比當前的HBM3提升了50%,總計提供10TB/秒的綜合帶寬。這使得新平台能夠運行比上一代大3.5倍的模型,並通過3倍更快的內存帶寬實現更高的性能。

NVIDIA的Grace Hopper Superchip得到了廣泛的應用,一些領先的製造商已經推出了Grace Hopper Superchip的系統。為了推動技術的廣泛應用,搭載HBM3e的下一代Grace Hopper 超級晶片與早些時候在COMPUTEX上發布的NVIDIA MGX™服務器規格完全兼容。通過MGX,任何系統製造商都可以迅速且具有成本效益地將Grace Hopper添加到超過100種不同的服務器變體中。

GH200將採用與H100相同的GPU,H100是Nvidia當前最強大且最受歡迎的AI產品。不過,GH200將具備三倍的內存容量。據Nvidia透露,搭載GH200的系統將在2024年第二季度開始上市。儘管Nvidia並未透露GH200的具體價格,但目前H100系列的售價約為40,000美元。

AI晶片龍頭的競爭

Nvidia正面臨來自競爭對手AMD的不斷增強的競爭壓力,隨著AMD計劃在今年第四季度擴大自家AI GPU的生產,AI硬件技術領域將進一步受到推動和創新。儘管Nvidia在市場中享有明顯的領先地位,但AMD的強大競爭力不容忽視。AMD不僅推出了具有優越記憶體和浮點運算能力的MI300企業級GPU系列,還在AMD資料中心與AI首映會上宣布了AMD Instinct平台,提供客戶快速部署需求。與此同時,Nvidia則展示了其創新能力,通過Grace Hopper Superchip的推出,結合了Grace架構CPU和Hopper架構的H100 GPU,提供高效的算力和節能特性。隨著兩家公司的競爭不斷升級,AI硬件技術將迎來更多的發展和突破。

![[AI郵報新年特輯] 2025 - 26 Top 5 AI 工具 & 大事件回顧](/content/images/size/w600/2026/02/image-33-1.png)