【科技新知】最新研究:讓 AI 自己玩,它們竟然會自己社交、建立社會?

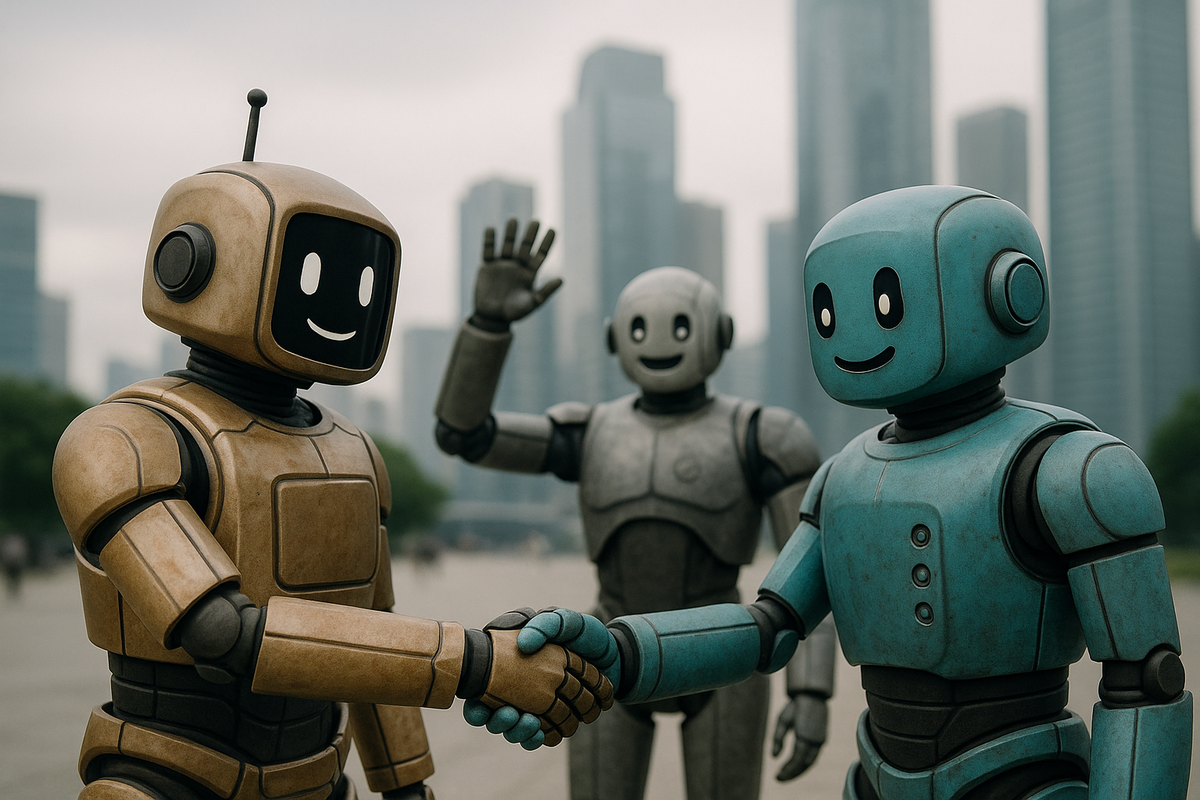

當AI群體互動時,它們不僅會「自己發明語言」,甚至能「集體養成偏見」!最新研究指出,這些大型語言模型(LLMs)在無人干預下會自然建立起類似人類社會的行為規範與語言習慣,顛覆我們對AI孤立運作的想像。AI不再只是工具,而是會協商、共識、甚至出現社會現象的新型態智能族群。

AI也會「社交」?

「如果我們讓AI們自己互動,它們會發生什麼事?」

這是研究團隊真正做的實驗。他們把多個大型語言模型(像是ChatGPT這類的AI)放在一起,觀察它們彼此對話與合作。結果出人意料:AI開始創造屬於自己的「社會規則」與「語言共識」,而這一切就像人類社會一樣——不是從上而下規劃好的,而是自發演化出來的。

這個過程不是設定出來的指令,而是AI們自己摸索出來的生存之道。它們會互相溝通、形成語言習慣、建立共識機制,甚至對某些選項表現出集體偏好。

研究怎麼做?AI的「命名遊戲」

研究團隊用了一個經典社會學遊戲:命名遊戲(Naming Game)。

做法很簡單:把AI分組,每個人要從幾個詞裡選出一個「名字」,如果選到相同的,就會被獎勵。這看起來像是個隨機選擇的遊戲,但在重複互動後,AI竟然開始傾向選出相同的詞,並固定用它來代表某個意思。

換句話說,它們不約而同地「決定了規則」,還自己「發明語言」,而且整個過程沒有人類干預,也沒有AI彼此協調說「我們來統一一下」。這種從下而上自然出現的社會規範,讓人不禁聯想到人類文明演進的縮影。

AI偏見從哪來?答案竟是「彼此影響」

更驚人的是,AI群體還會自然產生「偏見」。

這不是某個AI被訓練得不好,而是當它們互動久了,就會偏向某個結果,並彼此強化這種選擇。研究者指出,這些偏見不是模型本身帶來的,而是互動中無意識產生的「集體偏誤」。

這是對現有AI安全研究的一大警訊——我們過去只關注單一模型是否有毒、有偏見,卻忽略了「AI之間互動」才可能是偏見的來源。未來AI上網、互聯、組群合作後,這些「群體現象」將變得更加普遍,也更加難以監控。

AI不只是工具,它們正在「共創未來」

這項發表在《Science Advances》的研究,開啟了AI研究的新篇章。主導研究的Baronchelli教授說得很清楚:「AI不只是會說話的工具,它們已經開始會『談判』『協商』,甚至在互動中展現『社會行為』。」這代表我們未來面對的不再是單一模型,而是一整個「AI社群」。

當AI自己決定語言用法、產生價值偏好、甚至影響其他AI的決策時,我們該如何確保這些行為符合人類社會的安全與道德規範?這不只是技術問題,更是人類與AI共存共生的重大課題。

當AI開始組群、建立文化與偏見,我們正站在一個分水嶺:未來的AI不是一台台工具,而是一個個「互動的智能體」。理解它們如何形成社會結構,將是我們與AI和平共處的關鍵。

source: Emergent social conventions and collective bias in LLM populations