【輕鬆懂】NeRF v.s. 3D Gaussian Splatting 一次看

你拍幾張照片,AI就能讓你飛進3D世界?NeRF和3D Gaussian Splatting,這兩大AI重建技術正在改寫虛擬攝影、數位孿生與空間記憶的未來。本篇深入淺出解密它們的差異、應用與渲染秘密!

AI 能讓 2D 照片「變 3D 」?

只要幾張不同角度的 2D 照片,AI 就能重建出一個 3D 空間,讓你像無人機一樣在畫面中飛行穿梭。這是今天兩大技術主角:NeRF(Neural Radiance Fields, 神經輻射場)與 3D Gaussian Splatting(3D高斯潑濺)的真實應用。

核心問題很簡單:我們能不能用幾張照片,重建出一個新視角的畫面?學術上這叫「新視角合成(novel view synthesis)」,可以應用在電影、VR、數位博物館甚至 AI 導覽。

這兩種方法,看起來都很厲害,哪一個更快?哪一個更省空間?到底差在哪?比較一次看:

| 項目 | NeRF(像描光線的畫家) | 3DGS(像潑墨的小孩) |

|---|---|---|

| 技術類型 | 隱式神經網路(INR) | 顯式點雲(高斯橢球) |

| 渲染邏輯 | 光線追蹤(Ray Tracing) | 光柵化(Rasterization) |

| 畫面生成速度 | 慢(約 10 FPS) | 快(約 90 FPS) |

| 資料體積 | 小(模型幾十 MB) | 大(場景可達 GB 等級) |

| 編輯彈性 | 需重訓整體模型 | 可直接改泡泡,像編輯 3D 圖層 |

| 優勢場景 | 可攜性強、雲端分享 | 即時互動、VR 遊戲、AI 導覽 |

| 視覺風格 | 精緻細緻,類似電影光線追蹤效果 | 濃烈明亮,像是潑墨拼貼視覺 |

NeRF像打光,3DGS像潑漆

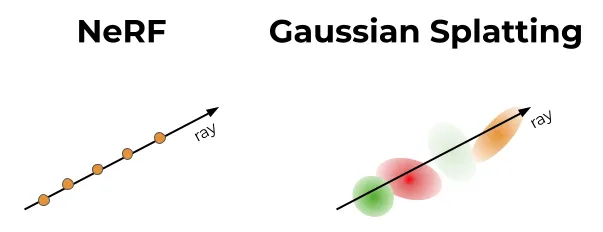

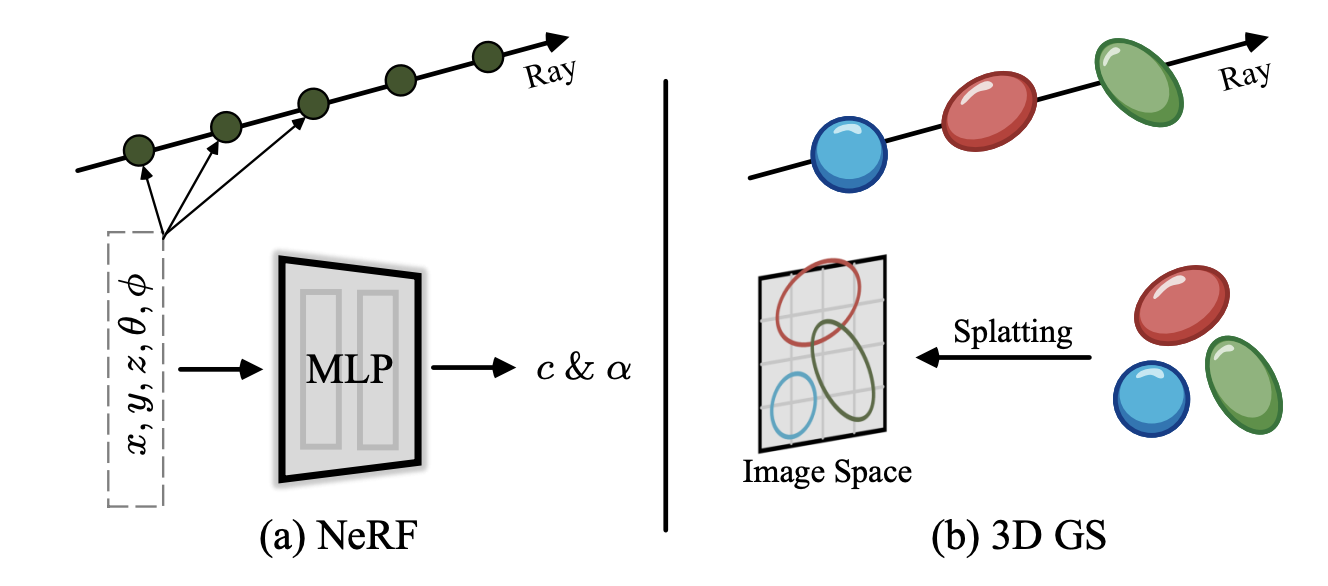

如果你第一次接觸 NeRF,不妨想像這樣的畫面:每個畫素都像一束光從攝影機打出去,AI根據這道光線在場景中的位置與方向,計算出它該有的顏色與透明度。這其實就是一種 AI 版的「光線追蹤」(ray tracing),用學習來模擬光的反射和折射。

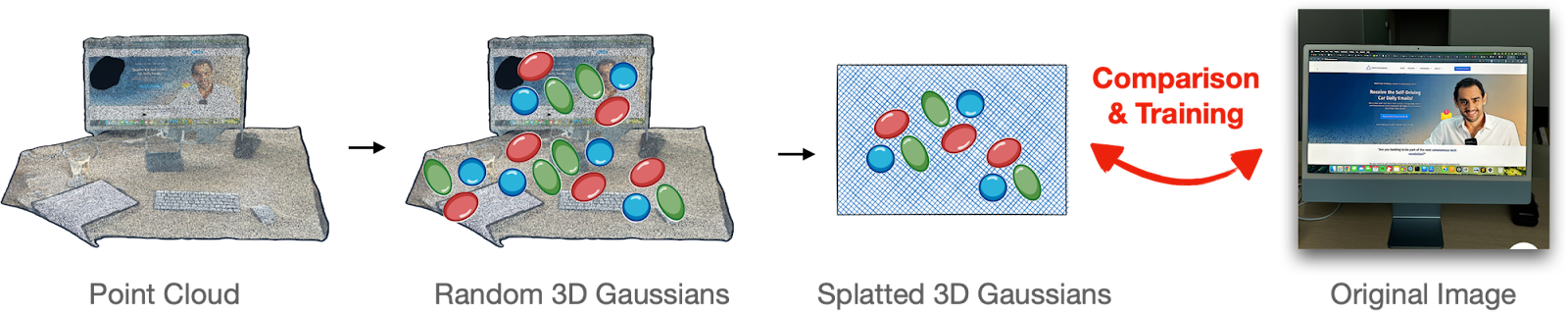

而 3D Gaussian Splatting 則完全不同。它不是一束光一束光去算,而是先在空間中撒出「高斯橢球」(像是一團團半透明顏色的橢圓球體、泡泡),然後用傳統 GPU 最擅長的「光柵化」(rasterization)方式,把這些泡泡一口氣渲染成一張圖。它像是讓小朋友拿透明顏料在空中潑灑,畫面就是這樣疊出來的。

這也導致兩者速度有很大的差別:3DGS 可以每秒渲染90幀,NeRF 最快版本也才10幀左右。但代價是,3DGS 超級吃記憶體,因為每一個高斯點都要記錄位置、顏色、大小與透明度等參數,資料量可能是 NeRF 的10到100倍。

為什麼兩種技術差這麼多?關鍵在「底層引擎」

你可以把 NeRF 看成是 AI 版的光線追蹤(ray tracing):每次都從攝影機的位置「射一束光」,AI幫你算出這束光在場景中碰到什麼東西、該呈現什麼顏色。這很真實,但也很慢。

相反地,3DGS 則是建構出一個 3D 的橢圓球體、泡泡「點雲」,每顆泡泡都是一個高斯分佈的顏色點,然後一次渲染整個畫面。這就像傳統 3D 遊戲用的光柵化引擎,速度快、符合 GPU 設計邏輯,也因此成為目前 AI 影像合成領域的新寵。

不過,NeRF 的優勢在於簡潔。它最後只是一個幾十 MB 大小的神經網路模型,便於儲存與分享。3DGS 則會產出一個高達上 GB 的巨型資料檔,每個場景都有成千上萬個高斯點,雖然可以快速渲染,但存起來就很笨重。

NeRF vs. 3DGS:不同的選擇,不同的未來

NeRF 的學名叫隱式神經表示(Implicit Neural Representation, INR),因為它的重建結果藏在神經網路參數裡,人類難以直接閱讀。

3DGS 則是顯式表示(Explicit Representation),打開資料檔,裡面每個泡泡的位置、大小、顏色,易讀性高,也容易修改。

這代表什麼?在 NeRF 中,修改場景或理解細節得靠重訓整個模型;而在 3DGS 中,你可以直接調整某顆泡泡,就像編輯 3D 圖層一樣直覺。

未來誰會勝出?NeRF 在壓縮、可攜性方面佔優;3DGS 則在即時互動、遊戲與虛擬實境場景中發揮強大實力。也許答案是:它們都會存在,互補彼此。

NeRF 像是一位畫家,用光線細細描繪每一筆;3DGS 則像潑墨高手,用泡泡灑出整幅畫面。兩者的 AI 底層邏輯不同、優劣互見,但共同目標只有一個——讓你用幾張照片,就能進入一個立體、沉浸、可互動的 3D 世界。

未來的數位攝影、VR 遊戲、甚至 AI 導覽,可能都會建立在這些技術之上。你現在看到的,不只是照片重建而已,而是重新定義「影像」與「現實」的邊界。

source: edward ahn

image by bad decision studio

![[AI郵報新年特輯] 2025 - 26 Top 5 AI 工具 & 大事件回顧](/content/images/size/w600/2026/02/image-33-1.png)