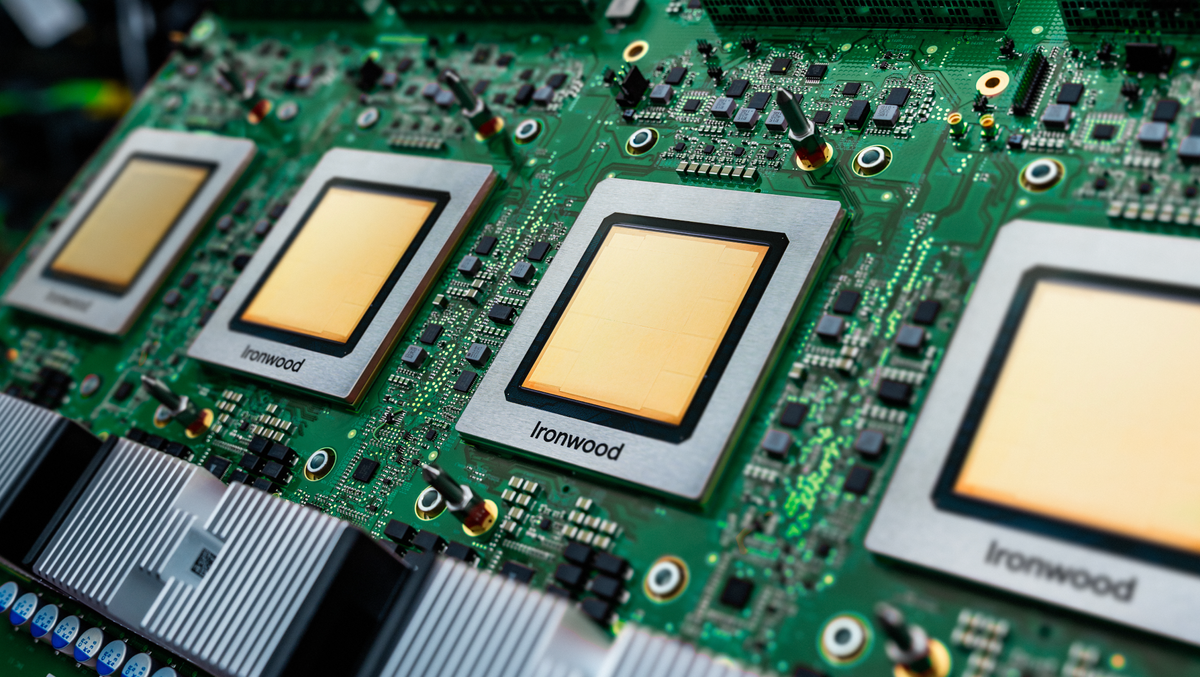

為什麼 Google 敢向 NVIDIA 叫板?Ironwood TPU 開火,Nvidia 霸主地位首現裂痕

Google Cloud 悄悄把 Ironwood TPU(第七代)切到 GA(General Availability),沒有大張旗鼓的 keynote,也沒有找一堆 KOL 排隊喊「mind blown」,就是默默地在控制台把價格表亮出來,然後把 9,216 顆晶片的 pod 直接掛網。這種「我做好了,你自己來玩」的態度,我給滿分。

Ironwood TPU

- 單顆 Ironwood 比 Trillium 快 4.2 倍(FP8)

- 單 pod 9,216 顆 → 42.5 ExaFLOPS

- HBM 容量與頻寬直接翻倍

- ICI(晶片間互聯)延遲砍到原本的 1/3,頻寬再拉 2.5 倍

- 整機櫃用上了 Optical Circuit Switch(OCS)

更變態的是,Google 這次把 SparseCore 升級到 2.0,專門吃 MoE 模型的稀疏激活。簡單說,你丟一個 DeepSeek R1、Grok-3、Claude 3.5 這種上兆參數的 MoE 進去,Ironwood 可以把那堆「只激活 10% 專家」的算力浪費直接砍到接近零。Anthropic 已經簽了「百萬顆 Ironwood」的訂單,準備把 Claude 下一代直接跑在上面,理由就一句:「NVIDIA 報價太離譜」。

然後是價格

雖然 Google 還是那句「定價請看官網」,從三個獨立來源拼湊出:

- Ironwood v7i(單顆)每小時大概落在 1.8~2.2 美元之間(比 B200 便宜快 70%)

- 整 pod 預留(committed use)打下去,算下來一顆不到 0.9 美元/小時

如果你今天要跑一個 2T 参数的 MoE 模型做推理,Ironwood 的每 1B tokens 成本可能直接殺進 0.3~0.4 美元區間。對,這已經比 Groq 的 LPU 還低了。

TPU vs Nvidia GPU 對決:Google Ironwood TPU v7p 直接硬剛 Nvidia Blackwell B200

| 項目 | Google Ironwood TPU v7p | Nvidia Blackwell B200 |

|---|---|---|

| 單晶片 FP8 性能 | 4,614 TFLOPS | ≈2,000 TFLOPS |

| 功耗 | ≈850 W | 1,200 W |

| 能量效率(性能/瓦特) | 2.0–2.5× | 基準 1× |

| 成本效率(性能/美元) | 3.5–4.0×(Cloud 租用) | 基準 1× |

| 晶片間互聯速度 | 9.6 Tb/s | 1.8 TB/s |

| 最大叢集規模 | 9,216 顆(共享 1.77 PB HBM) | 10,000+ 顆 |

| 軟體生態 | JAX / TensorFlow(需適配) | CUDA(400 萬開發者) |

| Meta 2027 部署計畫 | 主力轉向 TPU,數十億美元規模 | 仍保留但比例大幅下降 |

在「省電、省錢、超大規模」三個企業最在意的指標上,Ironwood 已經把 Blackwell 打到滿地找牙,唯一還能讓 Nvidia 睡得著覺的,就只剩 CUDA 生態這張王牌了。

從內部到企業租用,2026 年成長率超 40%

Google Cloud 強調 Ironwood 作為 AI Hypercomputer 核心,整合計算、網路、儲存與軟體,提升企業 AI 效率。TrendForce 分析,TPU v7 出貨 Q2 2025 年啟動,H2 爬坡,2026 年成長 40% 以上,Broadcom 與 GUC 受益於 ASIC 設計與供應鏈。

Meta 與 Broadcom 的入局將帶動台灣 GUC 業務成長25%,TSMC 7nm 產線滿載至2027 Q2。NVIDIA 股價盤後跌 1.2%,分析師擔憂「TPU 低價競爭」。

Source

3 things to know about Ironwood, our latest TPU

Meta Reportedly Weighs Google TPU Deployment in 2027, Boosting Broadcom, Taiwan’s GUC