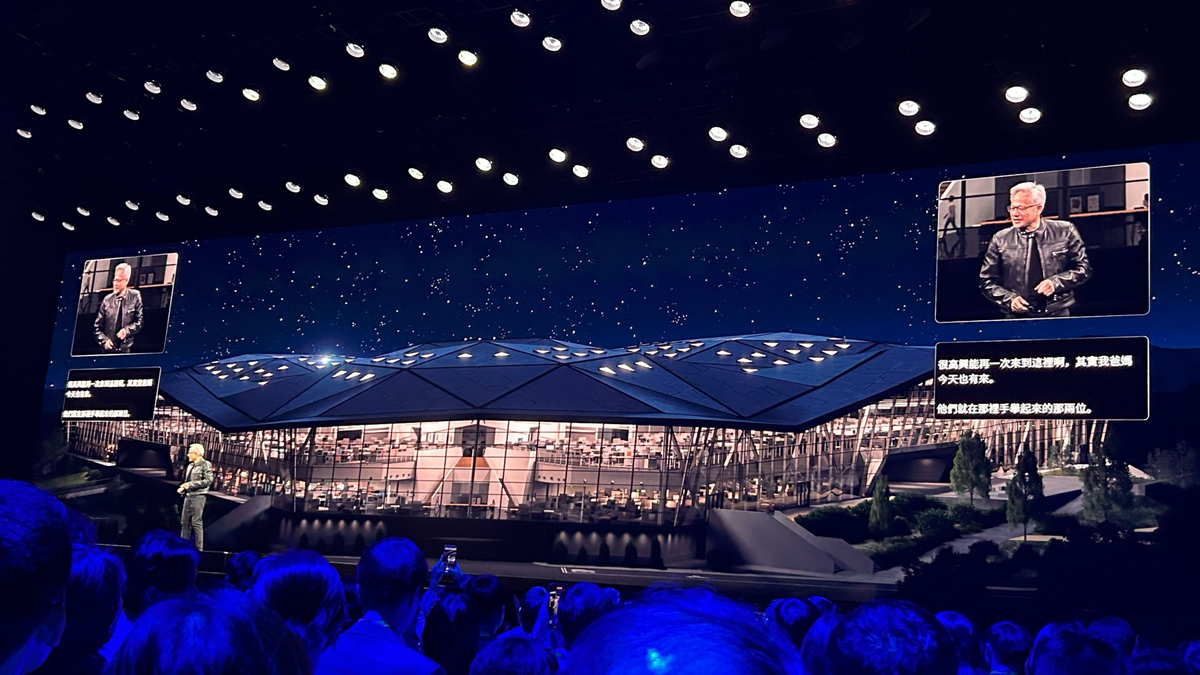

NVIDIA 黃仁勳揭示 AI 基礎設施與產業轉型宏大願景

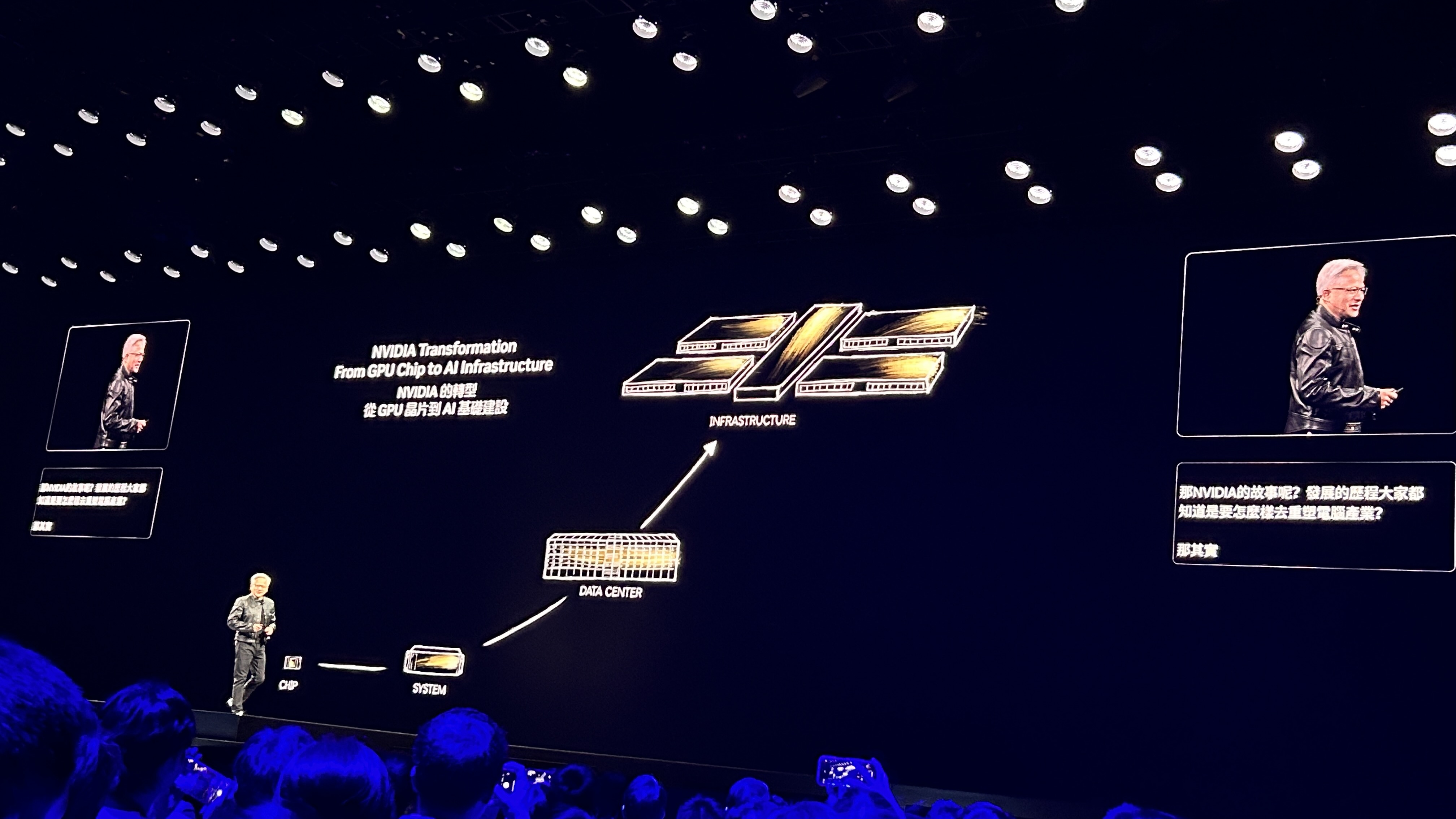

NVIDIA 創辦人暨執行長黃仁勳先生本日於台灣 Computex Taipei發表主題演講,深入闡述了 NVIDIA 如何從 GPU 晶片公司轉型為 AI 基礎設施公司,並描繪了 AI 將如何整合到未來十年內的一切事物中。他強調,NVIDIA 處於電腦生態系統的中心,這個中心正在創造新的市場。

[2025年5月19日,台灣台北]

NVIDIA 創辦人暨執行長黃仁勳先生本日於台灣 Computex Taipei發表主題演講,深入闡述了 NVIDIA 如何從 GPU 晶片公司轉型為 AI 基礎設施公司,並描繪了 AI 將如何整合到未來十年內的一切事物中。他強調,NVIDIA 處於電腦生態系統的中心,這個中心正在創造新的市場。

黃仁勳先生回顧了 NVIDIA 的發展歷程,從 1993 年成立之初專注於晶片業務,到 2006 年推出革命性的 CUDA 平台。到了 2016 年,NVIDIA 意識到新的運算方法 (即人工智慧) 已經來臨,這需要徹底改造技術堆疊的每一層。這促使 NVIDIA 發明了 DGX-1 系統,第一台 DGX-1 捐贈給了非營利組織 OpenAI,開啟了 AI 革命。

他進一步說明,現代 AI 應用與傳統軟體不同,需要許多處理器協同工作,為數百萬用戶提供服務。這使得資料中心的架構發生根本性改變,特別是電腦之間溝通的「東西向」網路變得極為重要。NVIDIA 在五年前收購了 Mellanox 公司,以增強在高效能運算和大規模分散式處理領域的「東西向」網路能力。如今,整個資料中心被視為一個運算單元。

黃仁勳先生將目前的 AI 轉型比擬為第一次工業革命中的電力基礎設施和後來的資訊基礎設施 (網際網路)。他指出,AI 基礎設施是建立在前兩者之上的新基礎設施,儘管現在說「智慧基礎設施」可能聽起來不合常理,但他承諾未來十年內 AI 將融入萬物。這些 AI 資料中心實際上是 AI「工廠」,它們消耗能源並生產極具價值的「tokens」。企業將開始衡量它們每小時生產多少 tokens,就像傳統工廠衡量產出一樣。他表示,這將市場機會從晶片產業的 3 億美元,擴展到代表數兆美元的資料中心機會,再到現在的數兆美元的 AI 工廠和 AI 基礎設施產業。

NVIDIA 的核心技術基於加速運算和 AI 的融合,特別是 CUDA-X 函式庫。加速運算與通用運算不同,它專注於加速應用程式中佔據大部分執行時間的少量程式碼。黃仁勳先生展示了廣泛的 CUDA-X 函式庫,涵蓋了從電腦繪圖 (GeForce RTX, DLSS) 到數字運算 (Kai)、無線電訊號處理 (Aerial for 5G/6G)、基因體學 (Paras)、醫學影像 (9)、天氣預測 (Earth 2)、量子運算 (Coup Quantum)、深度學習 (Megatron)、資料處理 (QDF)、機器學習 (QML)、最佳化 (Co-op)、模擬 (2DSS, 2Sparse),以及計算光學微影 (Ku Litho)。他特別提到 Ku Litho 正被台積電 (TSMC)、ASML、Synopsis 等重要夥伴廣泛使用,可將計算時間縮短數十倍。他強調 GeForce 將 AI 帶給了世界,而現在 AI 又回來徹底改變了 GeForce (指 DLSS 技術)。

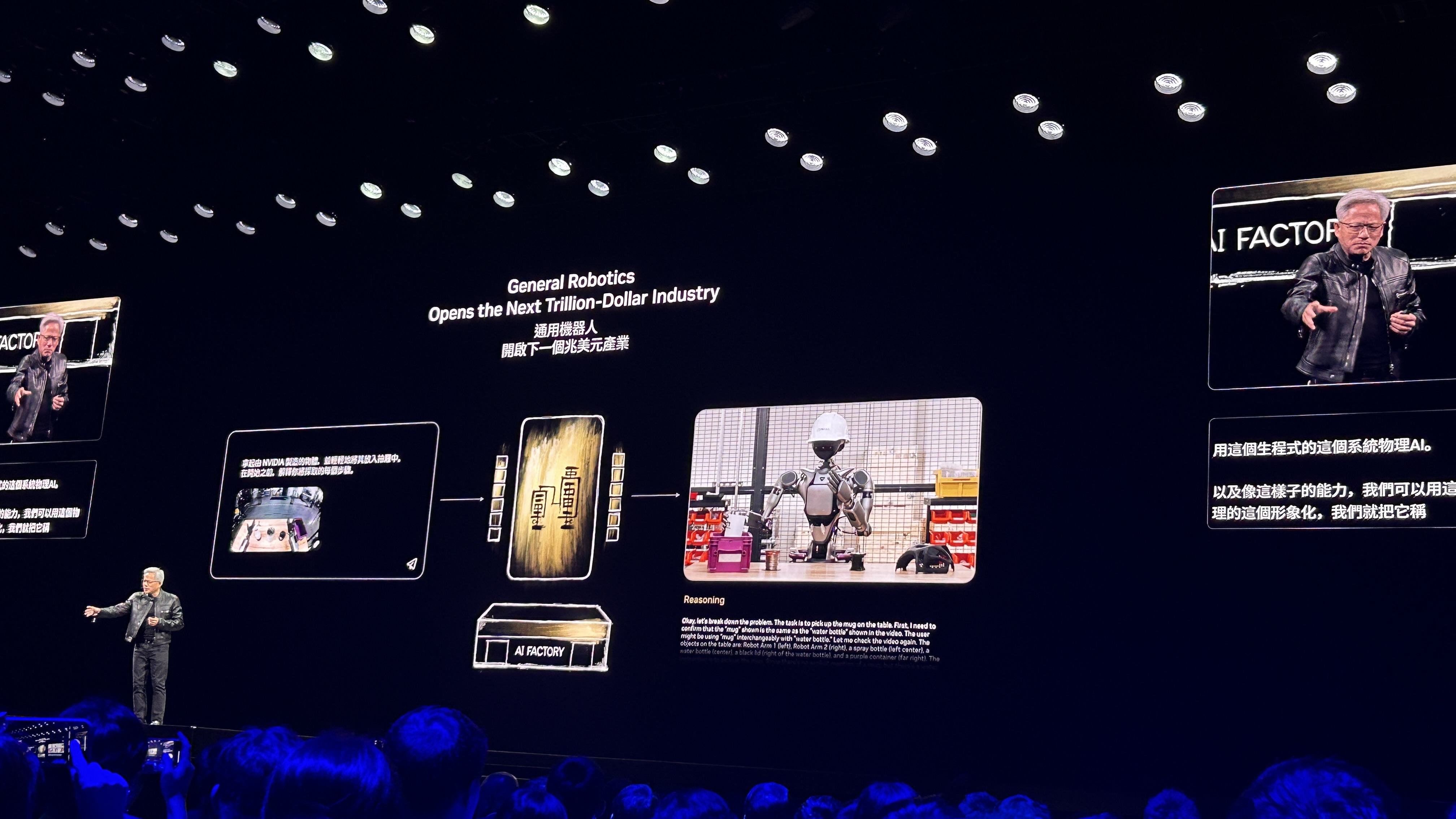

AI 的演進已從感知 AI (識別語音、圖像),進入生成式 AI (理解並生成文字、圖像、影片等,實現通用函數逼近器)。下一個階段是 Agentic AI (代理人 AI),它具備理解 (Understand)、思考 (Think) 和行動 (Act) 的能力。代理人 AI 可以分解目標、進行推理、使用工具,甚至與其他 AI 代理人協作。黃仁勳先生將它們比作「數位機器人」或「數位員工」,認為它們能幫助解決全球勞動力短缺問題,並透露 NVIDIA 內部所有軟體工程師現正使用數位代理人協助工作。

為了支援這些新的 AI 能力,NVIDIA 推出了革命性的新系統和基礎設施:

- Grace Blackwell (GB200/GB300): 設計用於推論時間擴展 (inference time scaling),實現「極快思考」。它能實現向上擴展 (scale up),將電腦變成巨型電腦,並能向外擴展 (scale out),連接多個電腦協同工作。GB300 比上一代 HGX H100 在推論效能上提升 1.5 倍,網路能力提升 2 倍。一個 GB200 節點的效能約等於 2018 年的 Sierra 超級電腦。

- NVLink: 全球最快的交換器,用於連接多個 GPU。GB200 系統中的 NVLink Spine 可以連接 72 個 Blackwell GPU (共 144 個 GPU 晶片),提供高達 130 Terabytes/秒 的全對全頻寬。這使得整個機架可以被視為一個「巨型 GPU」或「一個主機板」。

- AI 工廠: NVIDIA 正在建造的是 AI 工廠,而不是傳統資料中心。例如 XAI 的 Colossus 工廠 (代號 Stargate)。建造這些工廠需要龐大的投資,一個 1GW 的工廠可能需要 600 到 800 億美元,其中運算系統佔很大一部分。黑石 (Blackwell) 晶片的製造過程是與台積電 (TSMC)、Spil、Amkor、KYEC、鴻海 (Foxconn)、緯創 (Wistron)、廣達 (Quanta)、Dell、ASUS、技嘉 (Gigabyte)、HPE、Super Micro 等眾多台灣及全球夥伴共同合作的工程奇蹟。

- NVLink Fusion: 這是一項新的方案,允許合作夥伴將他們自己的 CPU、ASIC 或加速器與 NVIDIA 的 NVLink 技術整合,以構建半客製化的 AI 基礎設施,並利用 NVIDIA 的生態系統。合作夥伴包括聯發科 (MediaTek)、Elchip、Astera Labs、Marvell (用於 ASIC 整合),以及 Fujitsu、Qualcomm (用於 CPU 整合)。

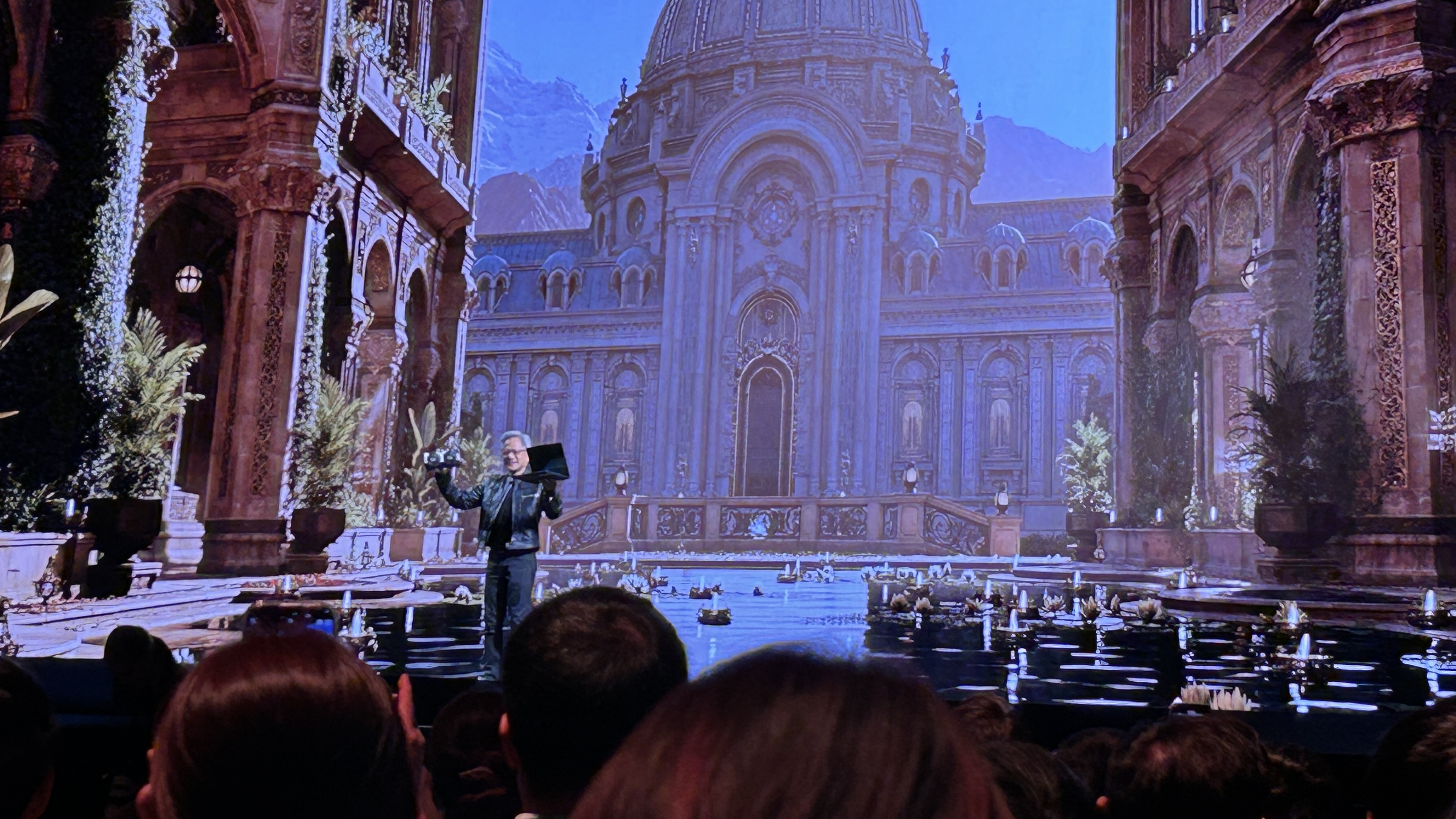

- DGX 系列: 黃仁勳先生發表了 DGX Spark,這是一款專為 AI 原生開發者、學生和研究人員設計的個人 AI 超級電腦,現已投入生產。他也展示了 DGX Station,這是一款桌邊超級電腦,能夠運行一萬億參數的 AI 模型。這兩款系統與大型系統使用相同的程式設計模型。

- 企業級 AI 平台: 為將 AI 引入傳統企業 IT 環境,NVIDIA 正在重塑運算、儲存和網路。全新的 RTX Pro Server 專為企業級 AI 代理人設計,它能運行傳統的 x86 軟體、虛擬化管理程式 (如 VMware、Red Hat、Nutanix) 和 Kubernetes,同時支援多模態 AI 工作負載 (文字、圖形、影片)。該伺服器使用 CX8 交換器,提供高達 800 Gbits/秒 的高速內部網路。黃仁勳先生展示了 RTX Pro Server 在 Llama 70B 模型推論等任務上相較於 Hopper H100 的顯著效能提升。

- AI 資料平台 (IQ): 這是一種新的儲存平台,專為語義查詢非結構化資料而非傳統的結構化資料 (如 SQL 資料庫) 設計。它涉及資料的嵌入、索引、搜尋和排序。未來的儲存系統將配備 GPU 運算節點。NVIDIA 提供了開源模型如 Llama NeMoTron 和 Nemo Retriever 來支援此平台。正在構建 AI 資料平台的合作夥伴包括 Dell、Hitachi、IBM 和 NetApp。

- AI Ops: 這是一個新的軟體層,用於管理數位員工 (AI 代理人),包括資料策劃、模型微調、評估和安全。在 AI Ops 領域與 NVIDIA 合作的夥伴包括 CrowdStrike、Dataiku、DataRobot、DataStax、Elastic、Nutanix、Red Hat、Trend Micro 和 Weights & Biases。

在演講的下篇,黃仁勳先生將進一步深入探討機器人、數位分身在產業中的應用,以及台灣在全球 AI 和機器人生態系統中扮演的關鍵角色。

(待續)