史丹佛研究揭示全球的人工智慧模型缺乏透明度

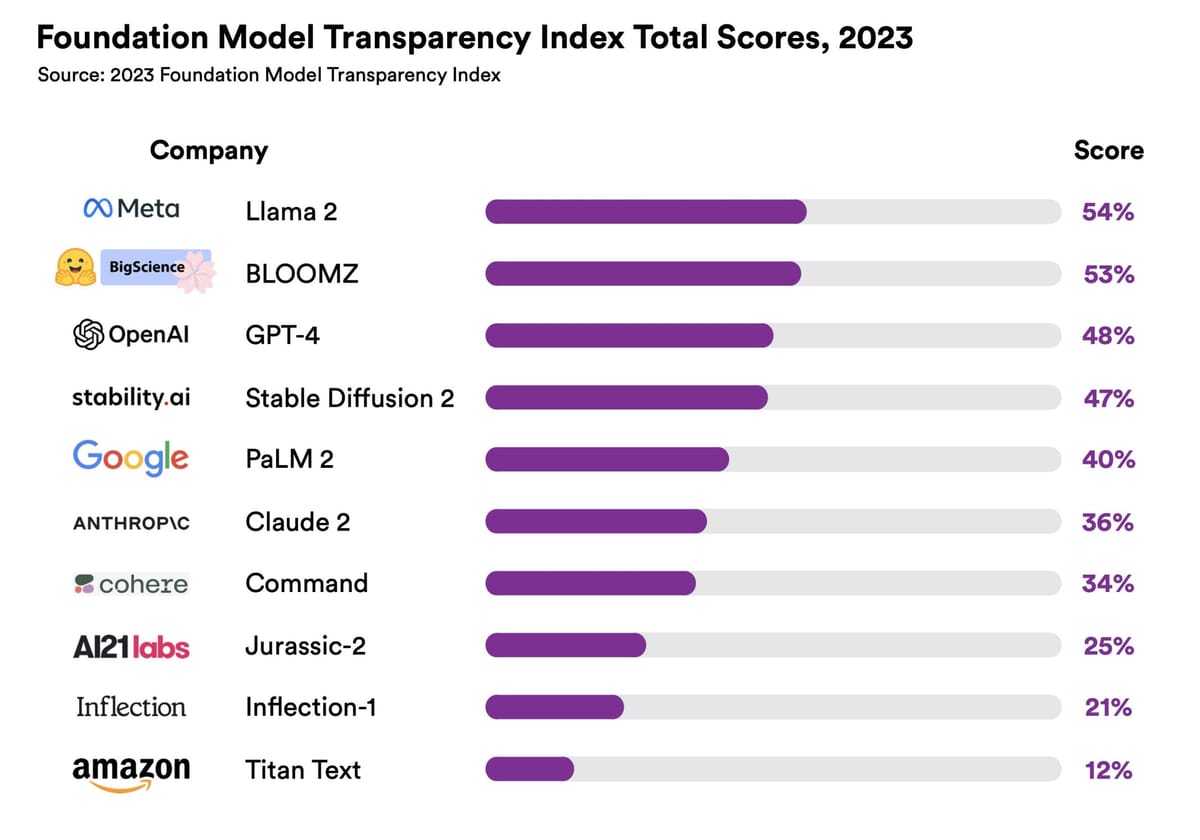

史丹佛人工智慧中心(HAI)最近發布了一份報告,揭示了AI基礎模型的開發者,包括像OpenAI和Meta這樣的公司,並未釋放有關其對社會潛在影響的足夠信息。史丹佛HAI推出了其基礎模型透明度指數,追踪了10個最受歡迎的AI模型的創建者是否披露有關他們的工作和人們如何使用他們系統的訊息。

史丹佛人工智慧中心(HAI)最近發布了一份報告,揭示了AI基礎模型的開發者,包括像OpenAI和Meta這樣的公司,並未釋放有關其對社會潛在影響的足夠信息。史丹佛HAI推出了其基礎模型透明度指數,追踪了10個最受歡迎的AI模型的創建者是否披露有關他們的工作和人們如何使用他們系統的訊息。

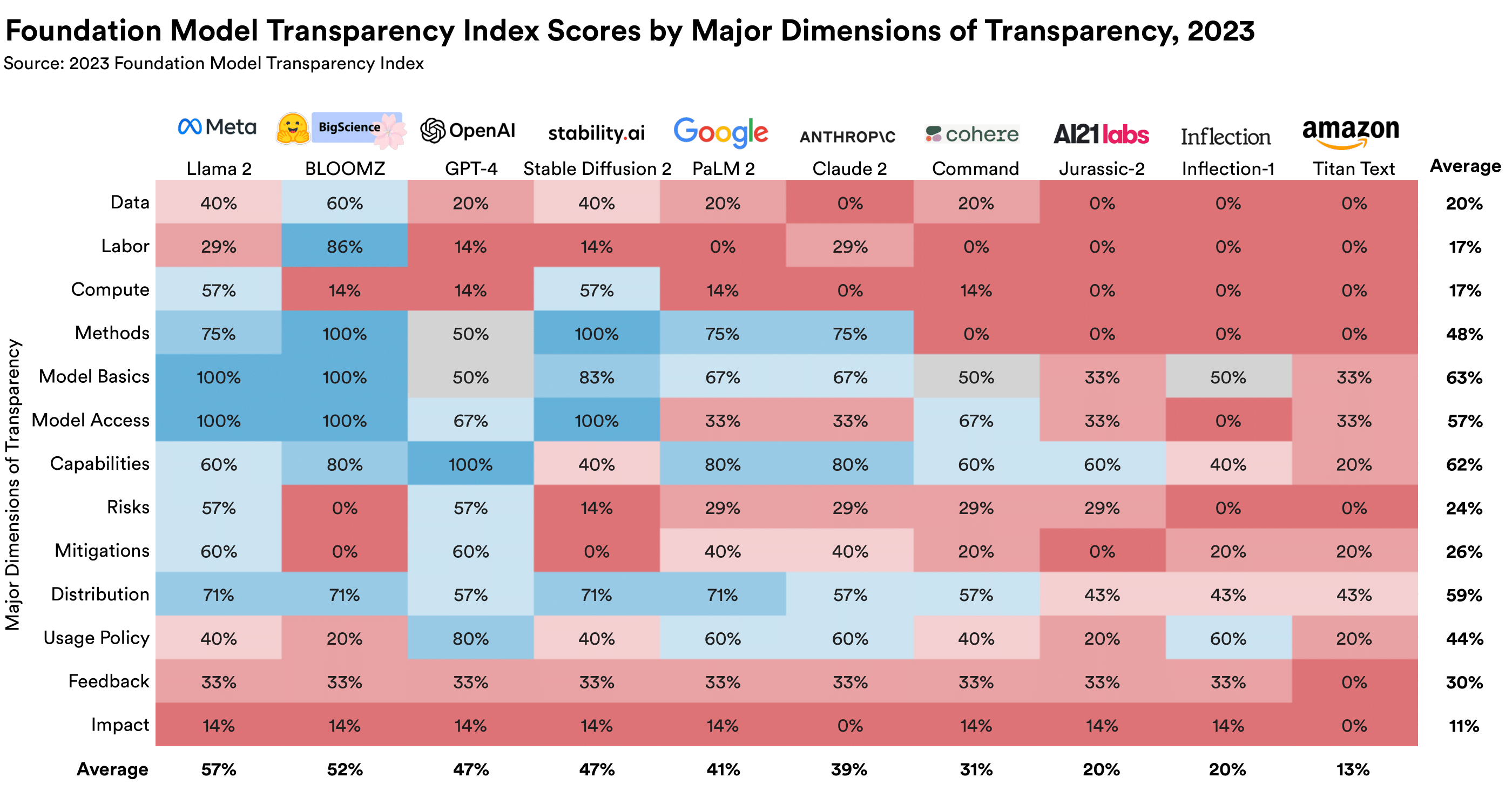

在評估的模型中,Meta的Llama 2得分最高,其次是BloomZ,然後是OpenAI的GPT-4。但是,沒有一個模型得到特別高的分數。透明度可以是一個廣泛的概念,研究人員的定義是基於100個指標的信息,關於模型是如何構建的,它們是如何工作的,以及人們是如何使用。

報告發現,沒有任何模型的創建者披露了任何有關社會影響的信息,包括在何處說明隱私、版權或偏見投訴。該指數的目標是為政府和公司提供一個基準,一些擬議的法規,如歐盟的AI法案,可能很快會迫使大型基礎模型的開發者提供透明度報告。

儘管生成式人工智慧有一個龐大開源社區,但該領域的這些大公司並不公開分享研究或代碼,OpenAI儘管在其名稱中有“開放”一詞,但由於競爭和安全方面的顧慮,不再公開其它研究資訊。