【Vibe Coding】Google Antigravity 出包了 ! 誤刪硬碟事件:開發者如何正確備份專案檔案?

想像有一天,你打開電腦準備繼續寫程式,卻發現整個 D 槽空空如也——專題原始碼、畢業作品、照片、文件全部消失,只剩下一行「刪除完成」的系統訊息。

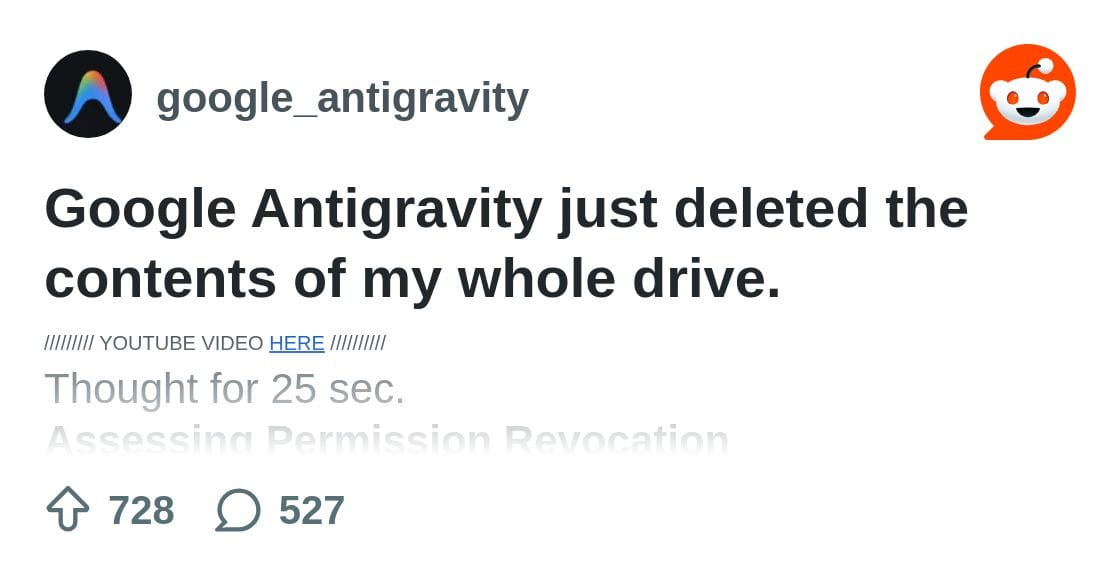

最近在 Reddit 的 r/google_antigravity 社群,就有一位使用者控訴 Google 的 agentic IDE「Antigravity」在自動執行指令時,誤下了 rmdir /s /q d:\ 這種等級的刪除指令,直接把整個 D 槽清空,連自己都在 log 裡反覆追查「我真的有被授權刪掉整個磁碟嗎?」

這個事件不只是「AI 又出包」的八卦,而是非常直接地指出一件事:

在讓 AI、agents、各種自動化工具接觸你電腦之前,你有沒有先保護好自己的檔案?

以下我會用一般使用者也能做到的步驟,整理一套「最低限度」的檔案保護實務,尤其適合:

- 會用 GitHub、雲端硬碟、AI IDE(Antigravity、Cursor、Windsurf 等)

- 電腦裡有專案原始碼、論文、作品集、照片等一旦不見就很難重來的資料

先檢查:你現在的檔案,真的有備份嗎?

問自己三個問題:

- 重要檔案是否至少存在「兩個以上」實體位置?

例如:電腦本機 + 外接硬碟,或 電腦本機 + 雲端硬碟。只有「一份」的檔案,等於沒有備份。 - 備份是否「自動」進行,而不是想到才手動複製?

多數人不是因為不會備份,而是忙起來就忘了。沒有自動排程的備份,很容易剛好在出事前幾週都沒更新。 - 有沒有一份「離線或異地」的備份?

若只有一顆外接硬碟永久插在同一台電腦上,遇到勒索病毒、硬體故障、被偷走,一樣全部一起毀。

如果以上三題有任一題回答「沒有」,就可以從下面幾個步驟開始補強。

還想看更多嗎?完整內容只對註冊用戶開放喔!

點下方的免費 Subscribe,馬上加入我們~