IBM 研究中心推出AI模擬芯片,將助於未來人工智慧的進步

IBM 研究中心引入了最先進的混合信號模擬 AI 芯片來運行各種 DNN 推理任務,在應對這些挑戰方面邁出了重要一步。它是第一款經過測試的模擬芯片,與數字芯片一樣擅長計算機視覺人工智能任務,同時能效顯著提高。這一突破發表在《自然電子》雜誌最近的一篇論文中,標誌著在實現高性能人工智能計算的同時大幅節省能源方面邁出了一大步

IBM 研究中心引入了最先進的混合信號模擬 AI 芯片來運行各種 DNN 推理任務,在應對這些挑戰方面邁出了重要一步。它是第一款經過測試的模擬芯片,與數字芯片一樣擅長計算機視覺人工智能任務,同時效能顯著提高。這一突破發表在《自然電子》雜誌最近的一篇論文中,標誌著在實現高性能人工智慧計算的同時大幅節省能源方面邁出了一大步。

在傳統數字計算架構上執行深度神經網絡的傳統方法在性能和能源效率方面存在局限性。這些數字系統需要內存和處理單元之間不斷的數據傳輸,從而減慢計算速度並降低能源優化。

為了應對這些挑戰,IBM 研究中心利用了模擬人工智慧的原理,模擬神經網絡在生物大腦中的運作方式。這種方法涉及使用納米級電阻存儲設備,特別是相變存儲器(PCM)來存儲突觸權重。

PCM 設備通過電脈衝改變其電導,從而實現突觸權重的連續值。這種模擬方法減少了對過多數據傳輸的需求,因為計算直接在內存中執行,從而提高了效率。

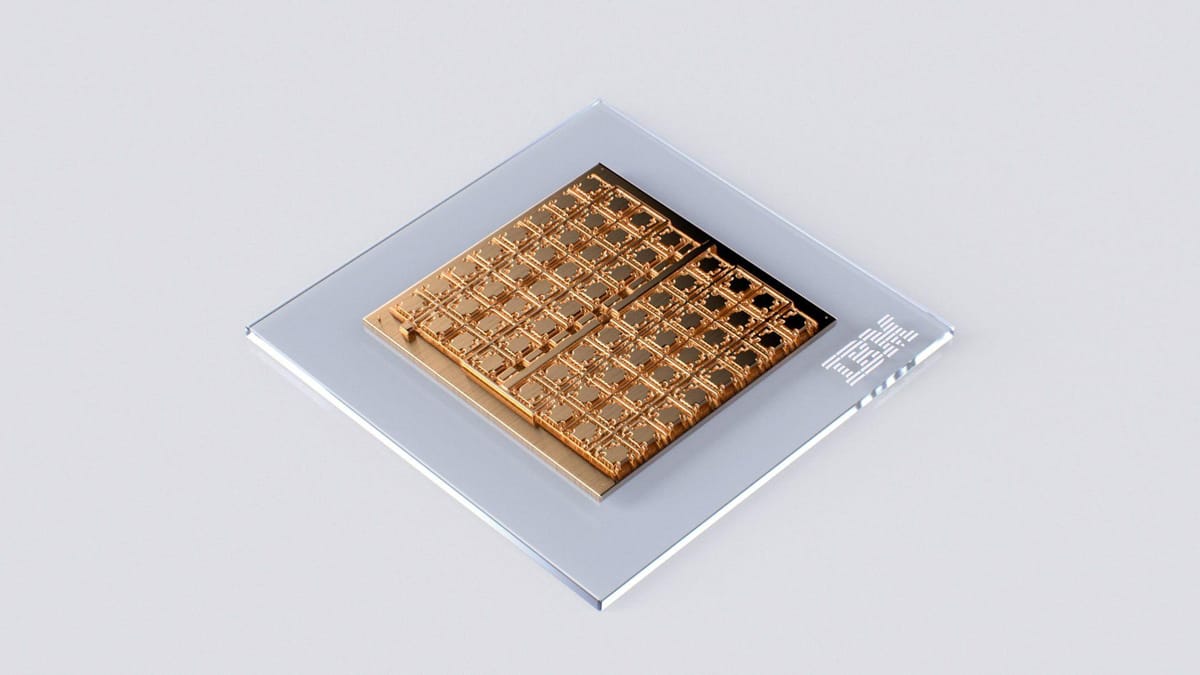

新推出的芯片是由64個模擬內存計算核心組成的尖端模擬AI解決方案。

每個內核都集成了突觸單元的交叉陣列以及緊湊的模數轉換器,可在模擬域和數字域之間無縫轉換。此外,每個核心內的數字處理單元管理非線性神經元激活函數和縮放操作。該芯片還擁有全球數字處理單元和用於互連的數字通信路徑。

研究團隊在CIFAR-10圖像數據集上實現了 92.81% 的準確率,展示了該芯片的強大性能,這對於模擬 AI 芯片來說是前所未有的精度水平。

每個區域的吞吐量(以每秒千兆操作數 (GOPS) 為單位)突顯了其與以前的內存計算芯片相比的卓越計算效率。這款創新芯片的節能設計加上增強的性能使其成為人工智慧硬件領域的里程碑式成就。

模擬人工智慧芯片獨特的架構和令人印象深刻的功能為未來在各種應用中實現節能人工智慧計算奠定了基礎。

IBM 研究院的突破標誌著一個關鍵時刻,將有助於推動未來幾年人工智慧技術的進步。