【AI 新手包 #5 打造工具自動化】不用寫程式!NotebookLM 向量資料庫簡易入門:把你的資料變成 AI 知識庫

不用寫程式也能打造 AI 知識庫!本文示範 NotebookLM 實測案例,教你如何用 RAG 技術把文件變成專屬 AI 助理,快速完成摘要、FAQ 與重點整理。

、AI 為什麼需要「自己的知識庫」

大部分人第一次用 ChatGPT,都會驚訝於它的知識廣度,彷彿任何問題都能回答。但當問題涉及到「自己的資料」時,例如公司內部文件、課堂筆記、研究報告,AI 卻常常一問三不知,甚至胡亂生成不正確的答案。這種狀況被稱為 AI 幻覺,也是目前生成式 AI 最大的痛點之一。

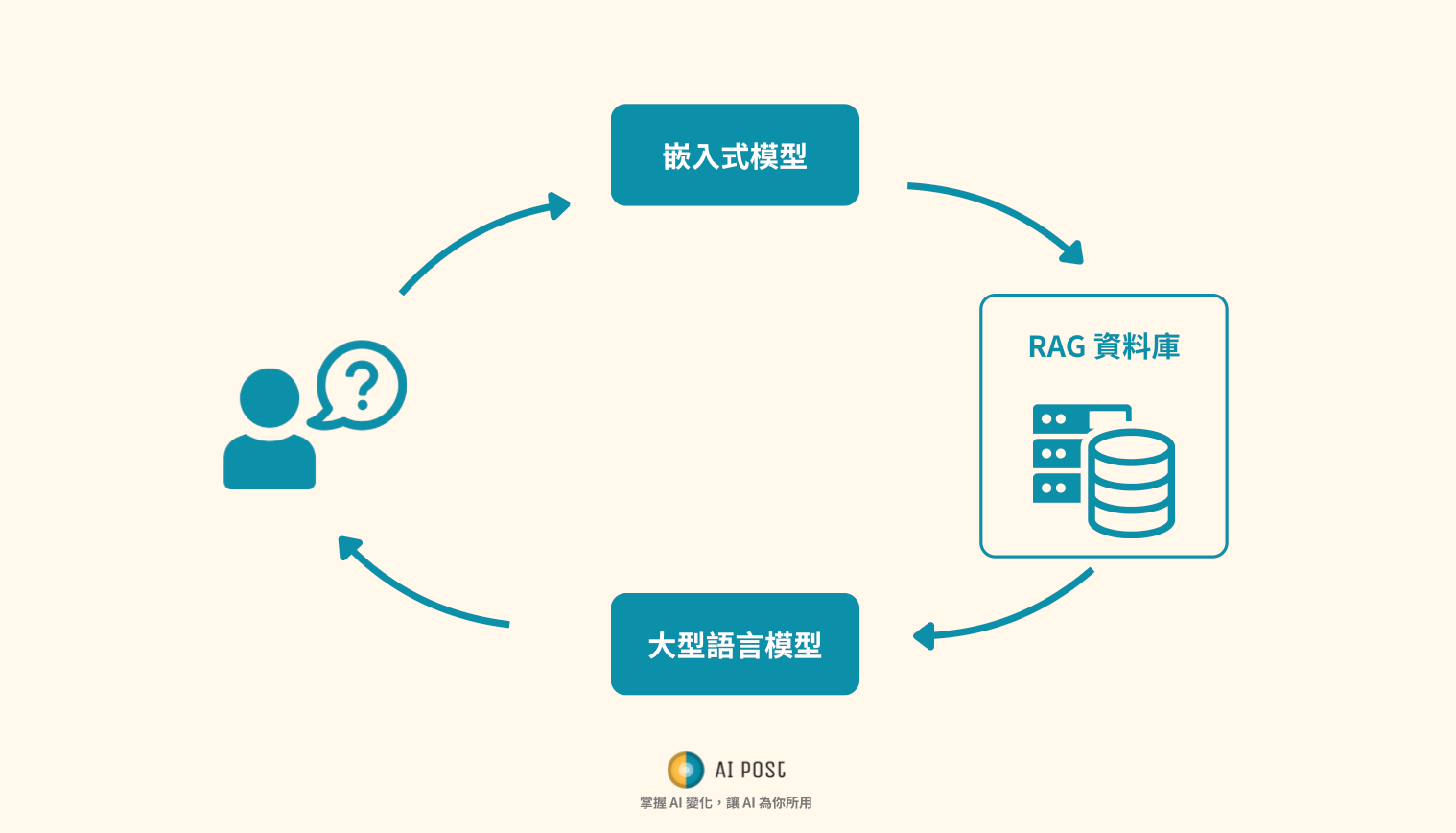

解決方法就是 RAG(檢索增強生成,Retrieval-Augmented Generation)。簡單來說,讓 AI 在回答之前,先去檢索一個你提供的資料庫,把找到的資訊作為依據,再用生成模型把答案組織出來。這樣一來,AI 就不再是「亂講」,而是基於你的文件來回覆。

本篇文章要帶你用一個完全零程式碼的工具 —— Google NotebookLM,實際操作一次「把資料變成 AI 知識庫」的流程。新手也能立刻上手,不需要任何技術背景。

什麼是 RAG?新手友善理解

在深入 NotebookLM 之前,先快速理解什麼是 RAG。

- Retrieval(檢索):當你提問時,系統會先到資料庫裡找最相關的內容。

- Generation(生成):再把找到的內容交給 AI,生成完整的回答。

和一般 AI 直接回答相比,差別就在於 先找資料,再組織答案。

舉例來說:

- 傳統 ChatGPT:問它「這份合約的解約條款是什麼?」→ 它可能亂猜,甚至捏造條款。

- RAG 系統:先檢索到合約中真正的第 12 條,然後再回答 → 結果精準、可追溯來源。

這就是為什麼 RAG 被視為下一代 AI 應用的基礎。

NotebookLM 是什麼?

NotebookLM 是 Google 推出的 AI 筆記與研究工具,核心功能就是幫助使用者把「自己的文件」變成 AI 可理解、可回答的知識庫。

主要特色有:

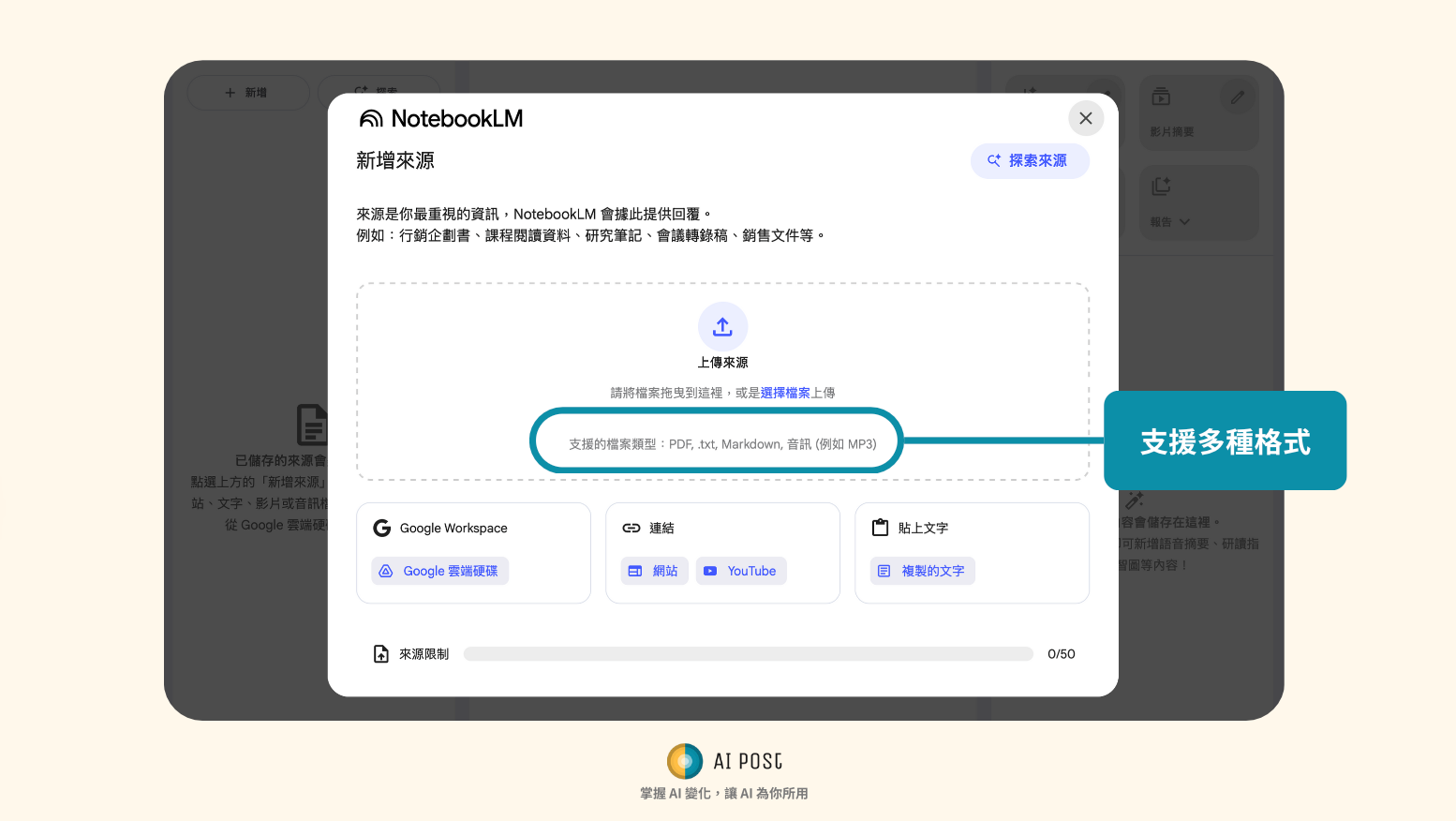

- 支援上傳 PDF、Google Docs、Slides、網站連結

- 自動生成 摘要、Q&A、導讀

- 提供 Audio Overview,把文件重點轉成可聽的語音版

- 回答時會標註來源,使用者能清楚知道答案來自哪個段落

換句話說,NotebookLM 就是「零程式碼版的 RAG」。你不需要處理任何技術細節,只要把文件放進去,AI 就能根據這些內容來回答。

實測案例:用 NotebookLM 打造 AI 知識庫

情境設定

假設你是一位行銷企劃,手上有:

- 一份公司年度行銷計畫(PDF)

- 一份市場研究報告(Google Doc)

- 一個競爭對手的公開網頁文章

你的目標是快速整理出 今年的行銷重點,並建立一個 競品分析 FAQ。傳統做法需要翻閱數百頁文件,現在我們要用 NotebookLM 來一次搞定。

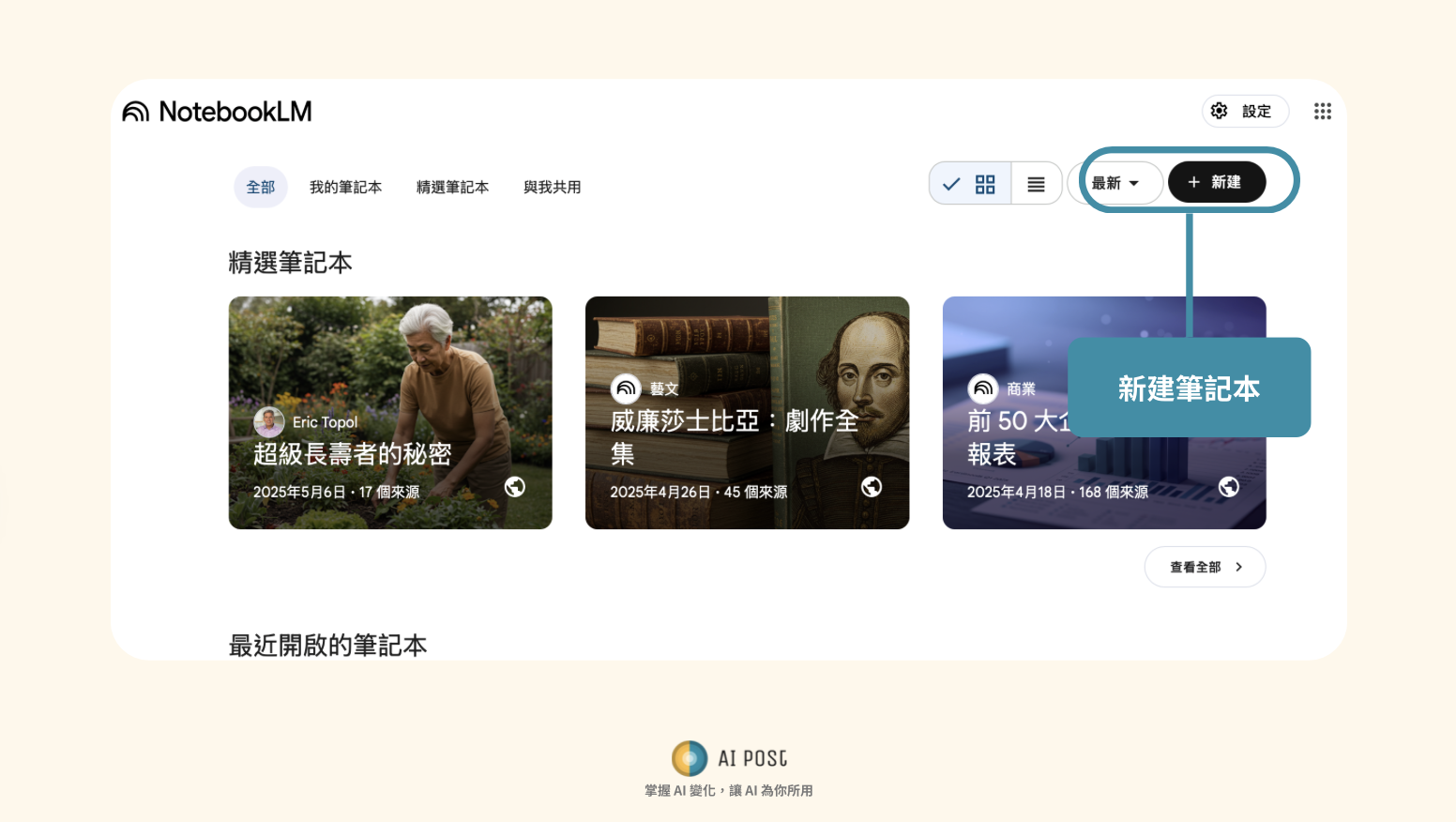

Step 1. 建立 Notebook

進入 NotebookLM,登入後點選「新建/New notebook」,輸入名稱,例如:Marketing_2025。

這就像建立一個「專案資料夾」,接下來的所有文件都會歸類在這個 notebook 裡。

Step 2. 上傳資料來源

把資料上傳:PDF、Google Doc、網址。系統會自動處理,將內容轉成 AI 可以檢索的格式。這一步完成後,你已經有了一個小型知識庫。

Step 3. 開始提問

在 NotebookLM 的對話框中輸入問題,例如:

- 「今年公司行銷的三大重點是什麼?」

- 「競爭對手有提到哪些新產品?」

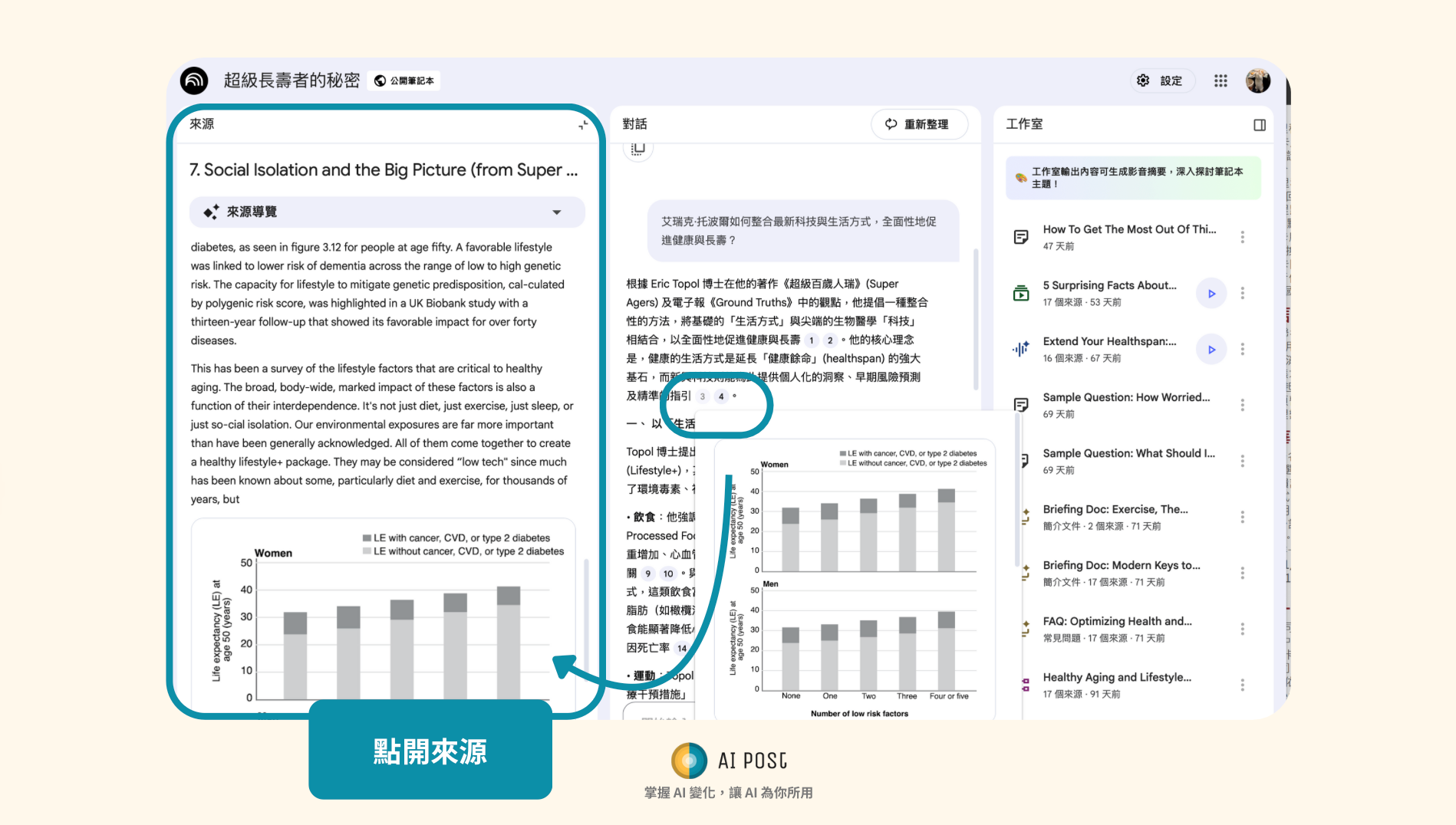

AI 會回覆一段文字,並且在每個答案後標註「來源引用」。點開來源,就能看到確切的文件段落,確保答案不是憑空捏造。

Step 4. 使用進階功能

NotebookLM 不只是單純的問答工具,它還有幾個實用功能:

- Summary(摘要):快速生成一份文件總結

- Study Guide(導讀):把內容轉換成條列式的 Q&A,適合整理成教學或 FAQ

- Audio Overview:自動生成語音 Podcast,把文件重點讀給你聽

例如,你可以直接得到「市場研究報告的重點摘要」,或是聽一個「競品策略 Podcast」,大幅減少閱讀時間。

Step 5. 應用成果

透過這樣的流程,你可以:

- 整理出一份「行銷策略 FAQ」給團隊成員

- 產出一份「競品動態摘要」作為簡報素材

- 在會議上快速回答「今年的 KPI 是什麼?」這類問題

NotebookLM 幫你把原本要花數小時整理的工作,縮短到幾分鐘內完成。

常見錯誤與解法

新手在使用 NotebookLM 時,可能會遇到以下問題:

- 上傳文件太雜,答案不聚焦

- 解法:為不同主題建立不同 notebook,例如「行銷」、「研究」、「客戶案例」。

- PDF 內容全是圖片,AI 讀不懂

- 解法:先用 OCR 工具把圖片轉換成文字,再上傳。

- 文件更新頻繁,NotebookLM 不會自動同步

- 解法:定期手動上傳更新版本,保持知識庫新鮮。

誰適合用 NotebookLM?

- 學生:整理課堂筆記、研究文獻,快速生成讀書大綱

- 研究員:上傳多份學術文章,讓 AI 幫忙做比較與摘要

- 上班族:處理會議紀錄、專案文件,快速建立 FAQ

- 創作者:把收集的資料輸入,AI 幫你整理成創作大綱

NotebookLM 的價值在於,它讓知識庫不再只是「被動存放」,而是變成「能主動回答的助理」。

未來趨勢:RAG 從工具走向自動化

NotebookLM 展示了最基礎的 RAG 應用:讓 AI 根據你的文件回答問題。但未來的方向會更進一步:

- 自動決策:不只回答,還能根據文件內容幫你執行動作(例如合約到期自動提醒)。

- 多模態資料庫:不僅支援文字,還能理解圖片、影音,讓 AI 能檢索更多樣的內容。

- 企業級應用:與內部系統、客服平台結合,變成真正的知識中樞。

對個人來說,NotebookLM 是一個「入門版的 AI 知識庫」,而對企業來說,這種技術正在成為生產力提升的關鍵。

結論:新手的最佳 AI 知識庫起點

如果你常常需要整理文件、翻找資料,NotebookLM 是最簡單的解法。它讓你不用寫程式,就能快速把文件變成 AI 知識庫,並隨時透過問答、摘要、音頻來獲得重點資訊。

它的優點是 上手簡單、效果直接,缺點則是 客製化與整合能力有限。但對於大部分新手來說,這已經足夠讓工作效率提升數倍。

如果想更進階,可以……

NotebookLM 適合當作入門工具,但如果你想把 RAG 用在更大規模的專案,可以考慮:

- 自架向量資料庫:如 FAISS(本地)、Weaviate、Pinecone(雲端)

- 結合 AI 框架:如 LangChain、LlamaIndex,讓知識庫變成客服機器人或內部助手

- 進階功能:控制資料切分方式、加入 metadata、設計更精準的檢索排序

這些進階玩法會需要更多技術背景,但能讓你從「簡單體驗」一路走向「專業級 RAG 系統」。

🎁 免費下載 GenAI 新手指南

我們幫你準備好一份入門手冊,教你從零開始,讓 AI 幫你做事。

新手包只對註冊用戶開放喔!

點下方的免費 Subscribe,馬上下載新手包!~